Роль технологій у розвитку штучного інтелекту

У контексті: Жодна компанія в індустрії не бажає повністю покладатися на чіпи Nvidia для навчання штучного інтелекту, хоча багато хто відчуває, що іншого вибору немає. Однак Apple вибрала інший шлях і, схоже, задоволена результатами: компанія обрала TPUs від Google для навчання своїх великих мовних моделей.

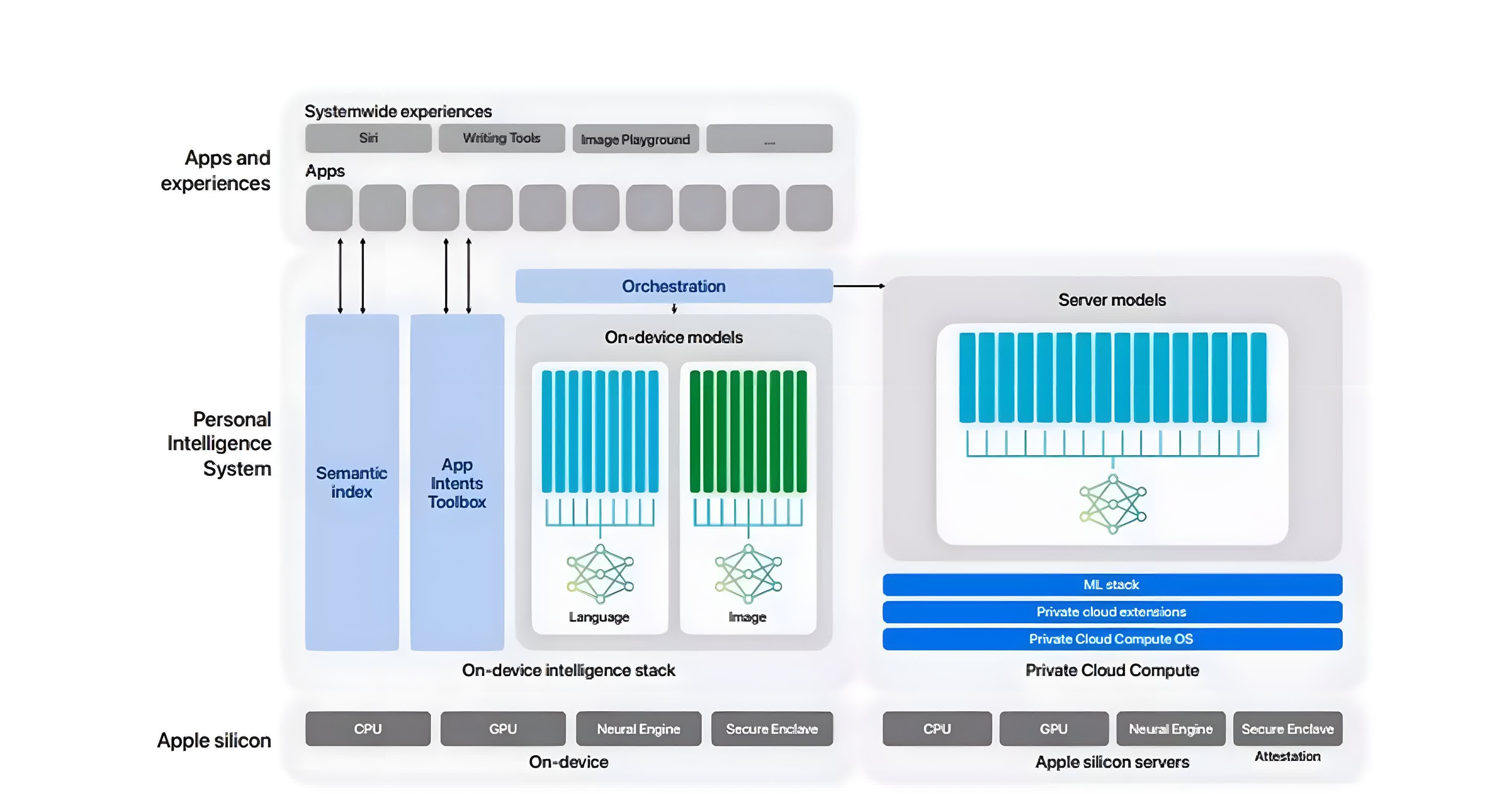

Рішення Apple щодо технологій AI

Apple виявила несподівану відкритість щодо того, як вона розробляла свої функції Apple Intelligence у нещодавно опублікованій науковій статті. Головна новина полягає в тому, що Apple вибрала чіпи TPU від Google – зокрема, TPU v4 і TPU v5 – замість графічних процесорів Nvidia для навчання своїх моделей. Це відхилення від галузевих норм, адже багато інших великих мовних моделей, таких як ті, що належать OpenAI та Meta, зазвичай використовують графічні процесори Nvidia.

Для тих, хто не знайомий, Google надає доступ до TPUs через свою платформу Google Cloud. Клієнти повинні розробляти програмне забезпечення на цій платформі, щоб використовувати чіпи.

Як Apple тренувала свої моделі

Ось як Apple проводила навчання своїх моделей. AFM-server, найбільша мовна модель Apple, була навчена за допомогою 8,192 чіпів TPU v4, сконфігурованих в 8 сегментів по 1,024 чіпи кожен, які з’єднувалися через мережу дата-центрів. Процес навчання для моделі AFM-server складався з трьох етапів: починаючи з 6.3 трильйонів токенів, потім 1 трильйона токенів і завершуючи розширенням контексту за допомогою 100 мільярдів токенів.

Модель AFM-on-device, скорочена версія серверної моделі, була отримана шляхом дистиляції з 6.4 мільярдів параметрів до 3 мільярдів параметрів. Ця модель на пристрої була навчена на кластері з 2,048 чіпів TPUv5p.

Використання даних для навчання

Apple використовувала дані зі свого веб-краулера Applebot, дотримуючись правил robots.txt, а також різноманітні ліцензовані високоякісні набори даних. До того ж використовувалися вибіркові коди, математичні та публічні набори даних.

Результати тестування моделей

Згідно з внутрішнім тестуванням Apple, як моделі AFM-server, так і AFM-on-device показали хороші результати в бенчмарках.

Чому Google TPUs стали вибором Apple

Існує кілька цікавих моментів. По-перше, детальне розкриття інформації в науковій статті є значущим для Apple, компанії, яка зазвичай не славиться своєю прозорістю. Це вказує на серйозні зусилля компанії продемонструвати свої досягнення у галузі штучного інтелекту.

По-друге, вибір на користь Google TPUs виглядає значущим. Графічні процесори Nvidia були в надзвичайно високому попиті та обмеженій кількості для навчання AI. Google, ймовірно, мав більш доступні TPUs, які Apple могла швидко використовувати для прискорення свого розвитку в галузі AI, що є вже запізнілим для ринку.

Продуктивність Google TPUs у порівнянні з Nvidia

Цікаво, що Apple виявила, що чіпи Google TPU v4 і TPU v5 надають необхідну обчислювальну потужність для навчання їхніх великих мовних моделей. 8,192 чіпи TPU v4, на яких була навчена модель AFM-server, забезпечують продуктивність, порівняну з графічними процесорами Nvidia H100 для цього виду робіт.

Також, як і багато інших компаній, Apple остерігається ставати надмірно залежною від Nvidia, яка наразі домінує на ринку чіпів для AI. Для компанії, яка ретельно контролює свій технологічний стек, рішення вибрати Google виглядає особливо обґрунтованим.