Що відбулося?

Microsoft представила модель BitNet b1.58 2B4T — новий тип великих мовних моделей, розроблений для максимальної ефективності. На відміну від звичайних моделей штучного інтелекту, які використовують 16- або 32-бітні числа з плаваючою комою для представлення ваг, BitNet використовує лише три дискретні значення: -1, 0 або +1. Такий підхід, відомий як тернарна квантизація, дозволяє зберігати кожну вагу лише в 1.58 біта. Це дає змогу значно зменшити використання пам’яті та забезпечити легшу роботу моделі на стандартному обладнанні, без необхідності в дорогих графічних процесорах (GPU), зазвичай потрібних для великих моделей ШІ.

Розробка моделі BitNet

Модель BitNet b1.58 2B4T була розроблена групою з розробки загального штучного інтелекту в Microsoft і містить два мільярди параметрів — внутрішніх значень, які дозволяють моделі розуміти та генерувати текст. Для компенсації низької точності ваг модель була навчена на величезному наборі даних, що складається з чотирьох трильйонів токенів, що відповідає вмісту 33 мільйонів книг. Таке обширне навчання дозволяє BitNet працювати на рівні, а в деяких випадках і перевершувати інші моделі подібного розміру, такі як Llama 3.2 1B від Meta, Gemma 3 1B від Google та Qwen 2.5 1.5B від Alibaba.

Продуктивність та ефективність

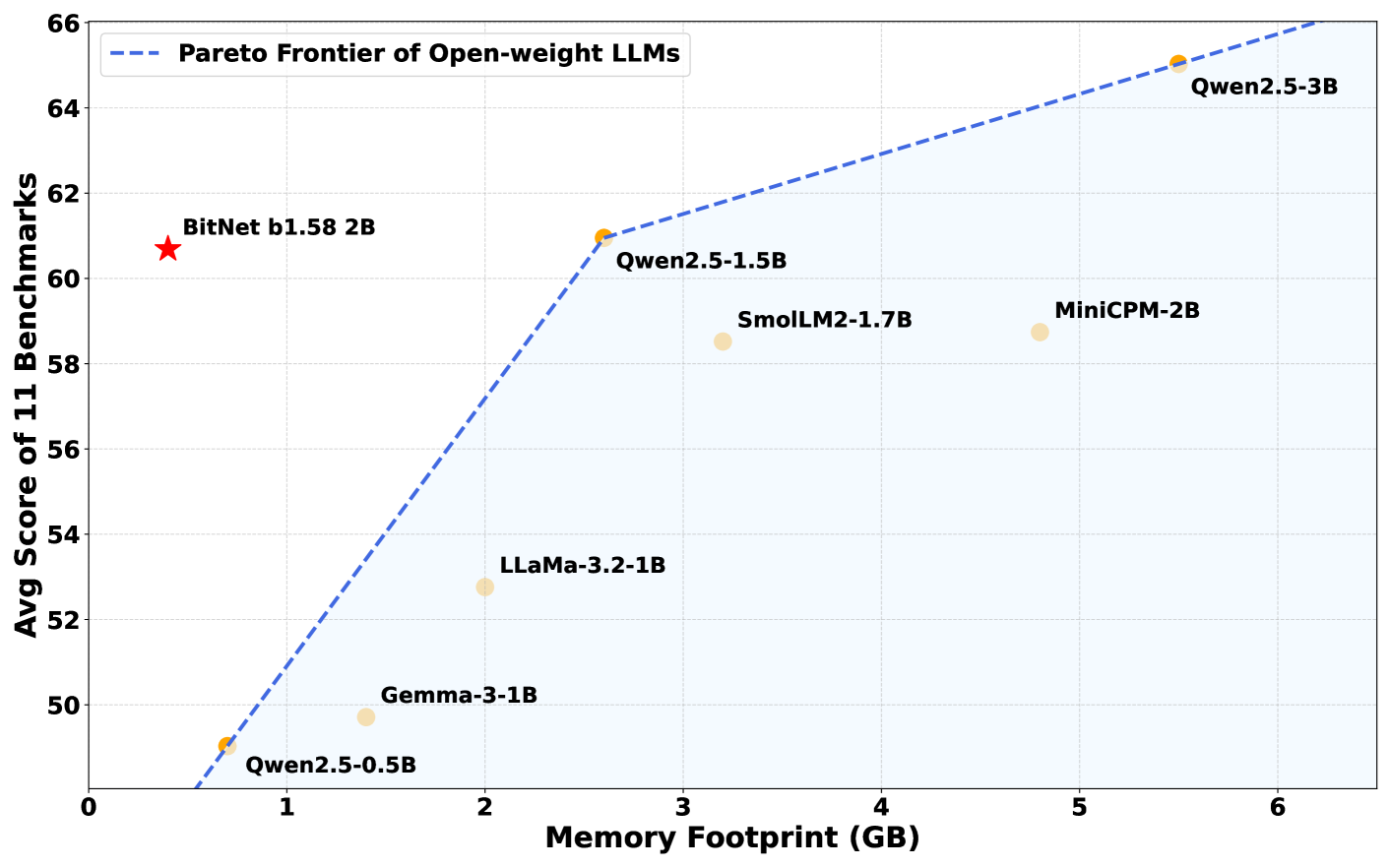

У бенчмаркових тестах модель BitNet b1.58 2B4T продемонструвала чудову продуктивність у різних завданнях, включаючи розв’язування математичних задач для молодших класів та питання, що потребують здатності до міркування на основі здорового глузду. У деяких оцінках вона навіть перевершила своїх конкурентів.

Ефективність пам’яті

Однією з основних переваг BitNet є її ефективність використання пам’яті. Модель потребує всього лише 400 МБ пам’яті — це менш ніж третина того, що зазвичай потрібно для подібних моделей. Завдяки цьому вона може працювати навіть на стандартних центральних процесорах (CPU), таких як чип M2 від Apple, без потреби в дорогих графічних процесорах або спеціалізованому апаратному забезпеченні для штучного інтелекту.

Оптимізація за допомогою bitnet.cpp

Цей рівень ефективності можливий завдяки спеціалізованому програмному забезпеченню bitnet.cpp, яке оптимізоване для повного використання тернарних ваг моделі. Ця програмна структура забезпечує швидку і легку роботу моделі на звичайних комп’ютерних пристроях.

Технологічні переваги BitNet

Традиційні бібліотеки штучного інтелекту, такі як Hugging Face’s Transformers, не пропонують такі ж переваги в продуктивності, як BitNet b1.58 2B4T, тому використання спеціалізованого фреймворку bitnet.cpp є необхідним. Цей фреймворк доступний на GitHub і наразі оптимізований для використання з центральними процесорами, хоча в майбутньому планується додати підтримку інших типів процесорів.

Скорочення точності моделей для збереження пам’яті

Ідея зниження точності моделі для економії пам’яті не є новою, адже дослідники вже давно вивчають можливості стиснення моделей. Однак більшість попередніх спроб полягала в перетворенні моделей з повною точністю після навчання, що часто призводило до втрати точності. BitNet b1.58 2B4T обирає інший підхід: вона тренується з нуля, використовуючи лише три значення ваги (-1, 0 та +1), що дозволяє уникнути багатьох проблем з точністю, які спостерігалися в попередніх методах.

Економія енергії та вплив на навколишнє середовище

Зниження точності моделі також має серйозні наслідки для енергетичних витрат. Враховуючи, що великі моделі ШІ зазвичай вимагають потужного обладнання та значних енергетичних ресурсів, це впливає на їхню вартість і екологічний слід. Однак завдяки простим обчисленням BitNet, здебільшого з операціями додавання замість множення, енергоспоживання зменшується значно.

За оцінками дослідників Microsoft, BitNet використовує від 85 до 96 відсотків менше енергії, ніж порівнянні моделі з повною точністю. Це відкриває можливості для запуску передових моделей ШІ без необхідності в хмарних суперкомп’ютерах, що знижує витрати та вплив на навколишнє середовище.

Обмеження та майбутнє розвитку BitNet

Попри численні переваги, BitNet b1.58 2B4T має деякі обмеження. Вона наразі підтримує лише певне апаратне забезпечення і потребує спеціалізованого фреймворку bitnet.cpp. Крім того, розмір вікна контексту (кількість тексту, який може обробити модель одночасно) є меншим, ніж у більш розвинених моделей.

Дослідники все ще вивчають, чому модель демонструє таку високу продуктивність при такій спрощеній архітектурі. Подальші дослідження зосереджені на розширенні її можливостей, зокрема підтримці більше мов та обробці більших текстів.